ВСЕ СТАТЬИ

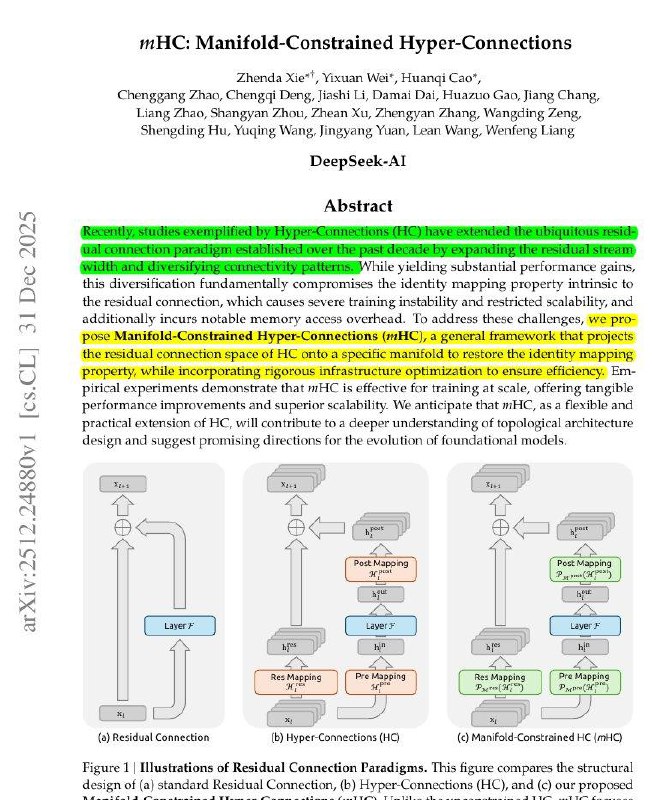

DeepSeek уже в первый день года выкатывает сильное обновление: важное улучшение архитектуры трансформеров. Китайцы редложила способ сделать shortcut-путь ( это когда выход слоя прибавляется к его же входу, то есть сеть не «заменяет» информацию, а добавляет к ней улучшенную версию) в трансформерах гибче, но при этом сохранить стабильность даже у очень больших моделей. В обычном трансформере каждый блок что-то считает, а потом просто добавляет результат к исходному сигналу. Это помогает информации проходить через много слоёв, не теряясь. Hyper-Connections меняют shortcut-путь. Был один поток, а стало несколько. Перед блоком модель выбирает, какие потоки подать на вычисления. Во время блока часть сигнала идёт «в обход», чтобы ничего не потерять. После блока всё снова аккуратно объединяется. То есть shortcut превращается из простого «input + output» в умный маршрутизатор сигналов. Проблема в том, что без ограничений такие смешивания могут усиливать сигнал слишком сильно или, наоборот, гасить его и большие модели начинают вести себя нестабильно. mHC решает это так: потоки остаются, но каждое смешивание работает как аккуратное усреднение. Сигнал не может «взорваться» или исчезнуть - он остаётся под контролем. Что это даёт на практике: - модели остаются стабильными даже на масштабе 27B, дают лучшее качество и не страдают от скачков лосса. Там, где обычные Hyper-Connections раздували сигнал до 3000×, mHC держат его примерно на уровне 1.6×. Если коротко: был один shortcut,. сделали несколько, но заставили их смешиваться безопасно. И трансформеры стали гибче и стабильнее. https://arxiv.org/abs/2512.24880 @ai_machinelearning_big_data #AI #DeepSeek #MachineLearning #NeuralNetworks #Research